オープンソースのプロダクトで社会に貢献していく

進化した日本語音声認識モデルReazonSpeech v2に見る開発者の思い

- BUSINESS:R&D

- OCCUPATION:RESEARCHER

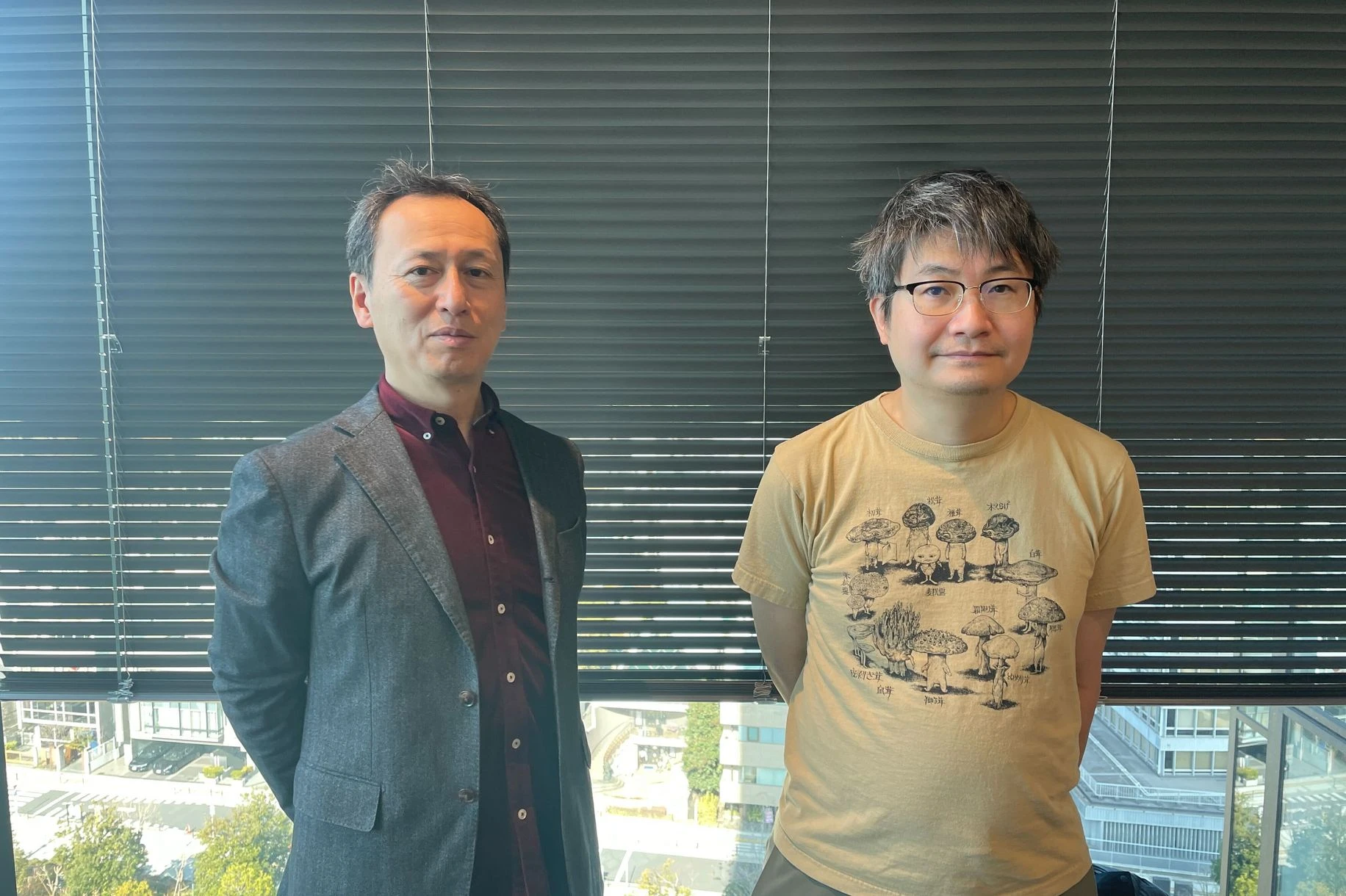

2024年2月にリリースされたReazonSpeech v2は、日本語音声コーパス(データベース)、高精度日本語音声認識モデルとして注目された従来のReazonSpeechと比較して、コーパス量が1.8倍の3万5,000時間、モデルの音声認識速度は約7倍と飛躍的な進化を遂げています。 アップデートを続けるReazonSpeechが目指すものとはなんなのか。開発担当者であるレアゾン・ヒューマンインタラクション研究所の森大二郎さんと末永匡さんにお話を聞いてみました。

森 大二郎 もり だいじろう 株式会社レアゾン・ホールディングス 取締役

九州芸術工科大学音響設計学科卒業。日本電信電話株式会社ヒューマンインタフェース研究所で情報検索技術の研究開発に従事。有限会社未来検索ブラジルで全文検索ソフトウェアを開発。株式会社レアゾン・ホールディングスでヒューマンインタラクション研究所を設立。

末永 匡 すえなが たすく 株式会社レアゾン・ホールディングス 研究企画部 部長

東京工業大学大学院卒。SNSマーケティング会社や大手IT企業、2度の起業など、幅広い経歴を持つ。ブログ検索システムや全文検索関連システム、ゲームアプリのプラットフォームの開発などを経験。2023年7月、かつて同僚だった森取締役に声をかけられたことで現職へ入社。現在は研究企画部長として、多言語コミュニケーション支援アプリの開発やAI人材獲得に努めている。

音声認識を身近で便利なインターフェイスに

レアゾン・ヒューマンインタラクション研究所ではオープンソースなプロダクトの開発に取り組まれています。そのなかで音声認識技術を選択された理由を教えていただけますか。

音声というものは私たちにとって非常に身近なものですよね。音声を使ったコミュニケーションのいいところは、書き言葉に比べるとレスポンスが速くて楽な点です。これがもし対面での会話だけでなく、パソコンやスマホを操作するときにも使えたら便利ですよね。指でキーボードを打ったり、タップしたりといったことと同じように、ユーザーインターフェイスのひとつとして音声認識があってものいいのではないか。理由は他にもあるのですが、私たちとしてはそんな思いもひとつあってReazonSpeechの開発に取り組んでいます。

2023年1月にリリースされたReazonSpeechは1万9,000時間という膨大なコーパス量が特徴でした。今回のReazonSpeech v2ではそれがさらに3万5,000時間に増えました。これほど大量のコーパスで、しかもオープンに使えるものは他にありません。

ReazonSpeechがリリースされる以前の日本では、商用でも自由に使える大規模なコーパスはありませんでした。誰でも自由に使える音声コーパスであること、それがReazonSpeechの推しポイントです。

実現できたのは、なにか技術的な進歩があったからでしょうか。

以前でしたら、権利に縛られずに自由に使える音声データがほしいと思ったら、研究室や実験室に人を招いてマイクの前で発話してもらうといった方法に頼らざるを得ませんでした。そこをReazonSpeechではテレビのワンセグ放送のデータを自動的に処理してコーパスにする手法をとりました。それによってコーパスの大規模化が実現しました。

日本では2019年の著作権法改正で、世界に先駆けて、データ分析のためであれば誰かに著作権のあるコンテンツであっても使ってかまわない、それを再配布してさらに商用で使ってもかまわない、という法律ができました。世界でもここまで踏み込んだ法律は見当たりません。ただ、あまりに進んだ法改正だったせいか、最初の数年間はみんなお互いの出方をさぐっている感じで様子見していたんですね。せっかくこんなにいい法律ができたのに誰も動かない。だったら自分たちが先陣を切って活用しようじゃないか。この法律を最大限に利用した自由な音声コーパスを作って世の中に広めようじゃないか。そんな想いから生まれたのがReazonSpeechでした。

地上波放送の活用で大量のコーパスを実現

法改正から実際にリリースされるまで、3~4年を要していますね。

私がレアゾンに入社したのが4年前です。実は私は以前からこうしたコーパスが作りたくてコツコツとデータを溜めていたのですが、音声認識用のコーパスとなると音声と同時に字幕データというか、文字列のデータも整理されている必要があるんですね。正確な音声と文字起こしデータがペアになっているものを大量に用意しなければならないのです。地上波放送のデータには字幕情報が入っているものが多いんです。いままではできなかったけれど、法改正でこれが自由なライセンスで配布するコーパスに使えるようになったのは大きかったですね。

地上波のワンセグ放送を使うにあたり、課題となったことはありましたか。

課題といえばシステム作りですね。番組の中で音声データと字幕データが流れていても、それが同じ時間帯に流れているとは限りません。また字幕データが音声を正確に文字にしているとは限らないわけです。そこで実際の開発では、まず既存の音声認識モデルで音声を文字起こししてみて、その結果と番組中の字幕を比較して合っているものを探し出すところから始めました。音声と字幕をマッチさせたものをコーパスデータにしました。こうした照合をとる処理のことを『アライメント』といいますが、これを実現するためのプログラムを書くのに時間と労力を費やしました。

お聞きしているだけでも、気の遠くなるような作業に思えます。

もうひとつの問題として、アライメント使用する既存の音声認識モデルもオープンで自由なものでなければいけないということがありました。どんなに高精度なものであっても音声認識モデル自身のライセンスがフリーでなければ、そこでつくったコーパスもフリーで配れません。ですから、開発当初はフリーで使える音声認識モデルをアライメントに使用し、小さなコーパスを作成しました。そのコーパスを用いて音声認識モデルを作成し、その音声認識モデルを用いてアライメントを行ってより大規模なコーパスを作成することを10数回繰り返して巨大なコーパスを構築していきました。

速度は7倍、句読点もついてリアルタイムでの書き起こしが可能に

その結果できたのが1万9,000時間のコーパスを持つReazonSpeechだったのですね。今回のReazonSpeech v2はわずか1年でのバージョンアップです。バージョン1との違いを教えてください。

コーパスが3万5,000時間に増えただけでなく、この1年だけでもオープンソースの音声認識モデルがいくつも発表されていたので、そのなかからNVIDIAが提供しているオープンソースツールキットのNeMoを新たに導入しました。これによってバージョン1のときと比べると音声認識速度が7倍となりました。普通は精度を稼ごうとすると速度が遅くなってしまったり、またその逆の現象が起きてしまったりといったトレードオフがつきものですが、ReazonSpeech v2ではこの精度と速度を高いレベルで両立させることができました。これがReazonSpeech v2の売りです。

より実用性が高まったのですね。

従来のReazonSpeechは、60分の録音データがあったとしたら、10数分で書き起こしが完了していました。これでも十分実用的だったと思うのですが、ReazonSpeech v2では、喋っているときにリアルタイムで書き起こしができるレベルになっています。ユースケースとしては、リモートで会話中に音声の文字列を画面に表示したり、リアルタイムで文字データを作成するといったことにも利用できるようになっています。パソコンで長めの文章を書くときにキーボードのかわりに音声で入力することもできます。ほかにも、例えば聴覚障害者の方が健常者と話すときも相手の言っていることをリアルタイムで文字で読むといったことができたりします。リアルタイム性が求められるさまざまな場面で応用範囲が広がっています。

バージョン1になかった句読点も付くようになりました。

ReazonSpeech v2では学習データから句読点を落とさないようにした訓練を行いました。そうしたら割といい感じで句読点が付くようになりました。

バージョン1のときは、正確な書き起こしをつくる上でよけいな記号や空白は全部削除する処理を入れていました。その流れで句読点もきれいに削除していたのですが、やはり「、」や「。」はあった方がいいだろうということで今回は加えてみました。ただ、その句読点が文字列の適切でない箇所に入ったりしたら困るので、機械学習させるためのデータはきちんとしたものを用意するように心がけました。

お話から、1年間でかなりの進化があったように感じられます。今後のアップデートもこうしたペースで進んでいくのでしょうか。

これはバージョン1を出したときからの思いですが、やはりこうしたものは継続してリリースしていくことが大事だと考えています。『言葉』というのは世の中の流れに沿って変わっていくものです。新しい言葉も次々に生まれるし、ボキャブラリーがどんどん変わっていくわけです。音声コーパスもそれを反映したモデルを更新していかないと、だんだん古臭い言葉しか認識できないものになってしまう。ですから、1年に1回は更新していくつもりでいます。

マルチモーダルでの開発を目指す『ReazonSpeech v3』

少し気の早い話ですが、来年予定しているバージョン3ではどんな挑戦をされるのでしょうか。

ぜひやりたいのが、これまでの音声や文字に話している人の表情などを加えたマルチモーダル学習です。人間は世界を認識するのに聴覚や視覚、嗅覚、味覚、触覚などの五感、さまざまな器官を介して入ってくる情報を使っています。これに対して、現在の我々のモデルはまだ一部しか使っていません。元となっているテレビ放送には当然映像情報があり、音声が流れるときはそれを口にしている話し手の顔が映っていることも多々あります。みなさんそうだと思いますが、私たちは人と話しているときに言葉だけでなく、相手がどんな顔をして話しているかを見て会話のヒントとしたり、相手の真意を読み取ったりしています。コーパスもそうした情報が加わればより高度なものとなるはずです。バージョン3ではそれを実現する予定です。

高度なモデルをリリースしていくのはもちろん、同時に進めたいと考えているのがコミュニティづくりです。ReazonSpeechは誰でも自由に使えるオープンなものですから、実際に使ってみた方やこうしたコーパス開発に興味のある方が集まる場を作りたいと考えています。

広い意味ではReazonSpeechに限らず、ヒューマン・インタラクションというものに興味のある方、そしてオープンソースのプロダクトをつくって社会に対して役立つものを発信していきたいと願っている方がいたら、ぜひ仲間に迎えたいですね。

まとめ

AIなど最新技術を用いたオープンイノベーションで社会を元気にしていく。ReazonSpeechとそれに続くReazonSpeech v2は、まさにそれを体現したプロダクトです。レアゾン・ヒューマンインタラクション研究所をふくめ、レアゾン・ホールディングスではこうした価値観に賛同していただける方々に広く門戸を開いています。ぜひ、ご興味のある方からのコンタクトをお待ちしています。